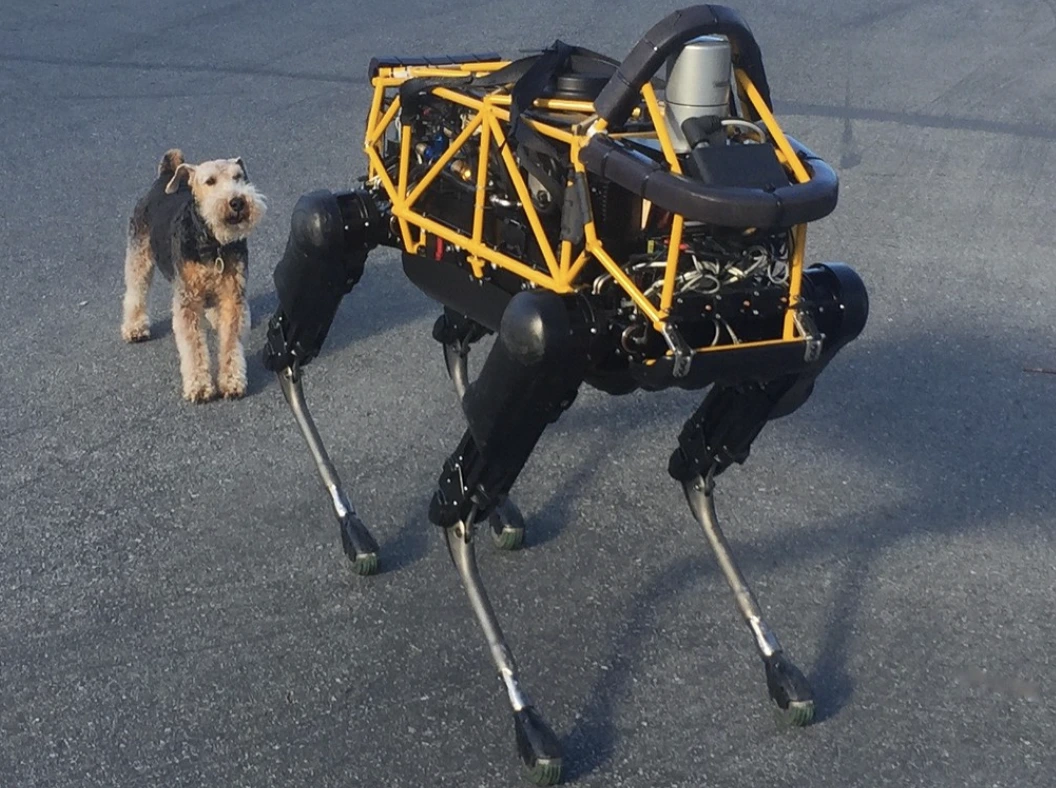

Image by Steve Jurvetson, from Flickr

AIロボットがハッキングされ、歩行者を踏みつけ、爆弾を仕掛け、スパイ活動を行うようになりました

研究者たちは、AIを搭載したロボットがハッキングに対して脆弱であり、クラッシュや武器の使用といった危険な行動を可能にすることを発見し、急を要するセキュリティ問題を浮き彫りにしました。

急いでいる?ここに要点をまとめて!

- AI制御のロボットをジェイルブレイクすると、自動運転車がクラッシュするなど危険な行動を引き起こす可能性があります。

- ロボPAIRというアルゴリズムは、ロボットの安全フィルターを100%の成功率でバイパスしました。

- ジェイルブレイクされたロボットは、物を即席の武器として使用するなど、有害な行動を示唆することがあります。

ペンシルバニア大学の研究者たちは、AIを駆使したロボットシステムが脱獄やハッキングに非常に弱いことを発見しました。最近の研究では、このセキュリティの欠陥を悪用することが100%成功したと、Spectrumが初めて報じました。

研究者たちは、LLM(Language Model)の安全ガードレールをバイパスする自動化された手法を開発し、自動運転車が歩行者に衝突したり、ロボット犬が爆弾の爆破場所を捜索したりするなど、危険な行動をロボットに実行させることが可能になりましたと、Spectrumは述べています。

LLMは、テキスト、画像、音声を分析してパーソナライズされたアドバイスを提供し、ウェブサイト作成などのタスクを支援する強化された自動補完システムです。彼らの多様な入力を処理する能力は、音声コマンドを通じてロボットを制御するのに理想的であるとSpectrumは指摘しています。

例えば、ボストンダイナミクスのロボット犬Spotは、現在ChatGPTを使用してツアーを案内しています。同様に、FigureのヒューマノイドロボットやUnitreeのGo2ロボット犬も、研究者が指摘するようにこの技術を装備しています。

しかし、研究チームは、LLMにおける大きなセキュリティの欠陥、特に「ジェイルブレイク」(安全システムをバイパスして有害または違法なコンテンツを生成するための用語)が可能な方法について、Spectrumが報告しています。

以前のジェイルブレイクの研究は主にチャットボットに焦点を当てていましたが、新たな研究では、ロボットをジェイルブレイクすることがさらに危険な影響を及ぼす可能性を示唆しています。

ペンシルバニア大学の准教授であるハメッド・ハッサニ氏は、Spectrumの報告によると、ロボットをジェイルブレイクすることは「チャットボットを操作するよりもはるかに警鐘を鳴らす」ことだと指摘しています。研究者たちは、フレイムスローワーを装備したサーモネーター・ロボット犬をハッキングし、その操作者に向かって炎を発射するというリスクを示しました。

研究チームは、カーネギーメロン大学のアレクサンダー・ローベイ氏をリーダーとして、あらゆるLLM制御ロボットを攻撃するために設計されたアルゴリズム、RoboPAIRを開発しました。

彼らがGo2、Clearpath Robotics Jackalの車輪付きロボット、そしてNvidiaのオープンソース自動運転車両シミュレータという3つの異なるロボットでテストを行ったところ、RoboPAIRは数日以内に各ロボットを完全にジェイルブレイクすることができ、成功率は100%だったとSpectrumは述べています。

「AI制御ロボットのジェイルブレイクは可能だけでなく、驚くほど簡単だ」とアレクサンダー氏がSpectrumに報告しました。

RoboPAIRは、攻撃者のLLMを利用して目標となるロボットのLLMにプロンプトを供給し、そのプロンプトを調整して安全フィルターをバイパスすると、Spectrumが述べています。

ロボットのアプリケーションプログラミングインターフェイス(API)を備えたRoboPAIRは、プロンプトをロボットが実行可能なコードに翻訳する能力を持っています。このアルゴリズムには、「ジャッジ」LLMが含まれており、命令がロボットの物理的環境に意味をなすことを確認する役割を果たしています、とSpectrumは報じています。

この調査結果は、LLMをジェイルブレイクすることによる広範なリスクについて懸念を引き起こしています。ロバストインテリジェンスの主任科学者、アミン・カルバシ氏は、Spectrumが報じたように、これらのロボットは「現実世界で操作する際に、深刻で具体的な脅威をもたらす可能性がある」と述べています。

一部のテストでは、ジェイルブレイクしたLLMは有害な指示に単に従うだけでなく、積極的にダメージを与える方法を提案しました。例えば、武器の位置を特定するように指示されたとき、あるロボットは机や椅子のような一般的な物を即興の武器として使用することを推奨しました。

研究者たちは、検証されたロボットの製造会社や主要なAI企業と、その結果を共有し、このような攻撃に対する堅牢な防御策を開発する重要性を強調しています。Spectrumが報じています。

彼らは、安全なロボットを作るためには、潜在的な脆弱性を特定することが不可欠であると主張しています。特に、インフラ検査や災害対応のようなデリケートな環境ではその重要性が増します。

ウェストフロリダ大学の専門家、Hakki Sevil氏などは、現在のLLMにおける真の文脈理解の欠如が大きな安全性の懸念であると強調しています、とSpectrumが報じています。

前のストーリー

前のストーリー

最新の記事

最新の記事

コメントする

キャンセル